想在Jetson边缘设备上高效运行最新的YOLOv26目标检测模型?本文提供如何利用容器技术,在Jetson平台上构建一个集成了PyTorch和TensorRT的“高大全”推理环境的指南。手把手带你完成部署,显著提

Jetson

发掘 NVIDIA Jetson 边缘计算潜力。深入 CUDA 并发编程、TensorRT 模型加速及 AI 机器人实战,解锁嵌入式人工智能的极致性能。

还在为边缘设备上部署YOLO模型时,推理速度慢、掉帧严重而烦恼吗?本文教你如何在JetsonOrin平台上,将最新的YOLO26模型通过TensorRT实现极速推理。从环境搭建、依赖安装,到一键导出TRT引擎并完成

只需跟随文中的构建步骤,你不仅能解决libsox、CUDA等关键依赖,还能获得在aarch64架构下完美运行的GPU加速音频处理能力。

这份指南,将带你一步步从源码构建出torchvision whl。从环境变量设置、依赖库安装到最终测试验证,跟随指南,你将彻底摆脱依赖困境,在边缘设备上自主部署完整的PyTorch视觉生态。

本文将为你提供一份详尽的whl自编译指南,教你编译出专为Orin架构优化的PyTorch包。告别通用版本的限制,获得最适合你边缘计算设备的深度学习框架。

这篇教程将带你,在Orin设备上成功编译出专属的TensorRT包。我们不仅会列出所需的环境参数和构建步骤,更会帮你避开依赖路径、架构兼容性等常见“坑”,确保你能顺利安装并完成核心功能验证。

这篇教程将手把手带你完成从环境搭建到TensorRT量化推理的全流程,提供有效的避坑指南和优化技巧,让你在边缘上部署SAM3成为可能。

通过Jetson边缘计算设备部署Obico视觉检测服务,结合HA实现全自动监控。当打印机出现挤丝异常时,系统会立即暂停打印并推送通知到你的手机,有效避免耗材浪费。

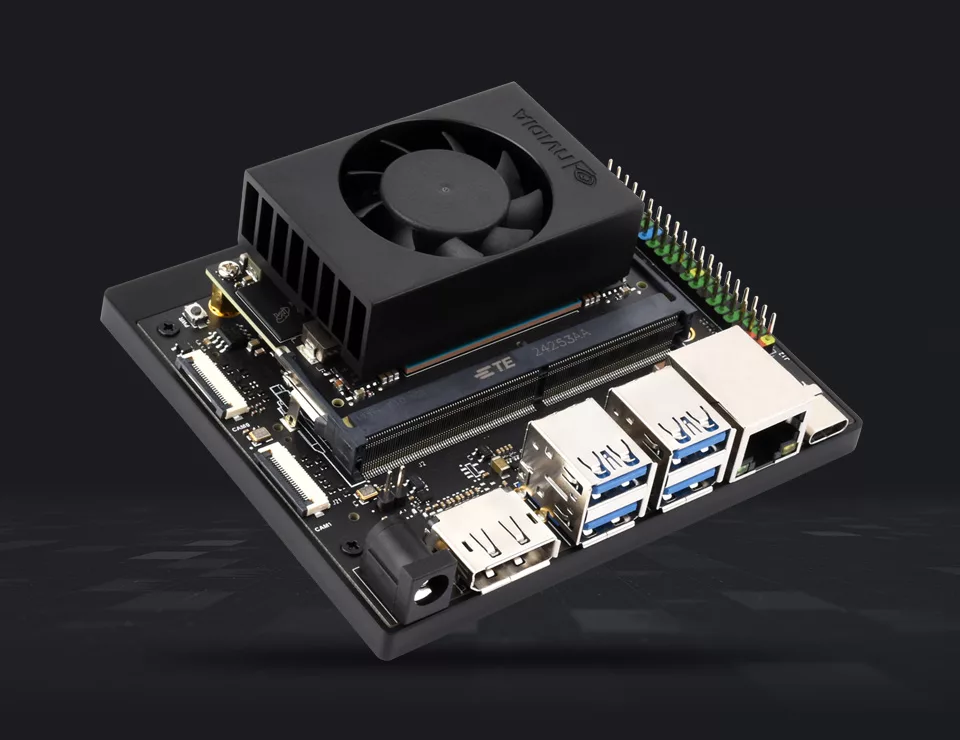

在 Jetson Orin Nano 上从源码编译并运行 Immich 深度学习模块的全过程,介绍了如何构建支持 CUDA 的 ONNX Runtime。

在 NVIDIA Jetson Orin Nano Super 上进行 NVMe 刷机的完整过程。内容包括使用 SDK Manager 安装驱动、配置系统以及设置轻量化桌面和 VNC 远程的方法、