引

还在为边缘端推理掉帧而头疼?YOLO26 + Jetson Orin 或许是目前的终极解决方案。支持全链路量化加速,专为边缘侧算力优化。不用改底层代码,几行命令实现 TensorRT 加速——极简的 YOLO 部署指南。

搭建环境

YOLO26 的推理需要 PyTorch(带 CUDA )和 ultralytics 的包,关于前者可以参考我之前的自编译教程

亦或是通过 Jetson Zoo - eLinux.org 根据自己的 JP版本 下载预编译的 whl 文件,注意⚠️ 如果是较新的版本,如 cuDNN 为9也无法安装,因为它是在8的环境来编译的,下面给出安装方案

ls /usr/lib/aarch64-linux-gnu/libcudnn.so.* # 尾号即 cuDNN版本,大于8可以选别的方案了

curl -LsSf https://astral.sh/uv/install.sh | sh # 首先安装 UV,安装过的可跳过

mkdir -p yolo26

cd yolo26

uv venv .venv --python 3.10 # 创建一个工作区以及虚拟环境

uv pip install ultralytics # 安装 YOLO 官方的超集包

wget https://developer.download.nvidia.cn/compute/redist/jp/v60dp/pytorch/torch-2.2.0a0+6a974be.nv23.11-cp310-cp310-linux_aarch64.whl -O torch-2.2.0-cp310-cp310-linux_aarch64.whl

uv pip uninstall torch

uv pip install torch-2.2.0a0+6a974be-cp310-cp310-linux_aarch64.whl

# 下载并安装 torch

如果既不想自编译也没有合适的版本 怎么办呢?别急,还可以通过 container 来跑 dusty-nv/jetson-containers: Machine Learning Containers for NVIDIA Jetson and JetPack-L4T (与本文相关性不太大,后期可能专门出一期教程)

教程已出 https://nvcc-v.com/2026/01/17/jetson-container-trt-yolo26-inference-guide/

这里我还是根据自编译的 whl 来跑,因为自由度更高,我也分享了 whl 在 GitHub 上,如果 JetPack 为 6.2.x 都可以尝试安装

curl -LsSf https://astral.sh/uv/install.sh | sh # 首先安装 UV,安装过的可跳过

mkdir -p yolo26

cd yolo26

uv venv .venv --python 3.10 # 创建一个工作区以及虚拟环境

uv pip install ultralytics # 安装 YOLO 官方的超集包

wget https://github.com/Shattered217/Jetson-Orin-Nano-Wheels/releases/download/6.2.1rc1/torch-2.3.0a0+git97ff6cf-cp310-cp310-linux_aarch64.whl

wget https://github.com/Shattered217/Jetson-Orin-Nano-Wheels/releases/download/6.2.1rc1/torchvision-0.18.0-cp310-cp310-linux_aarch64.whl

uv pip install torch-2.3.0a0+git97ff6cf-cp310-cp310-linux_aarch64.whl

uv pip install torchvision-0.18.0-cp310-cp310-linux_aarch64.whl

# 安装 torch 包

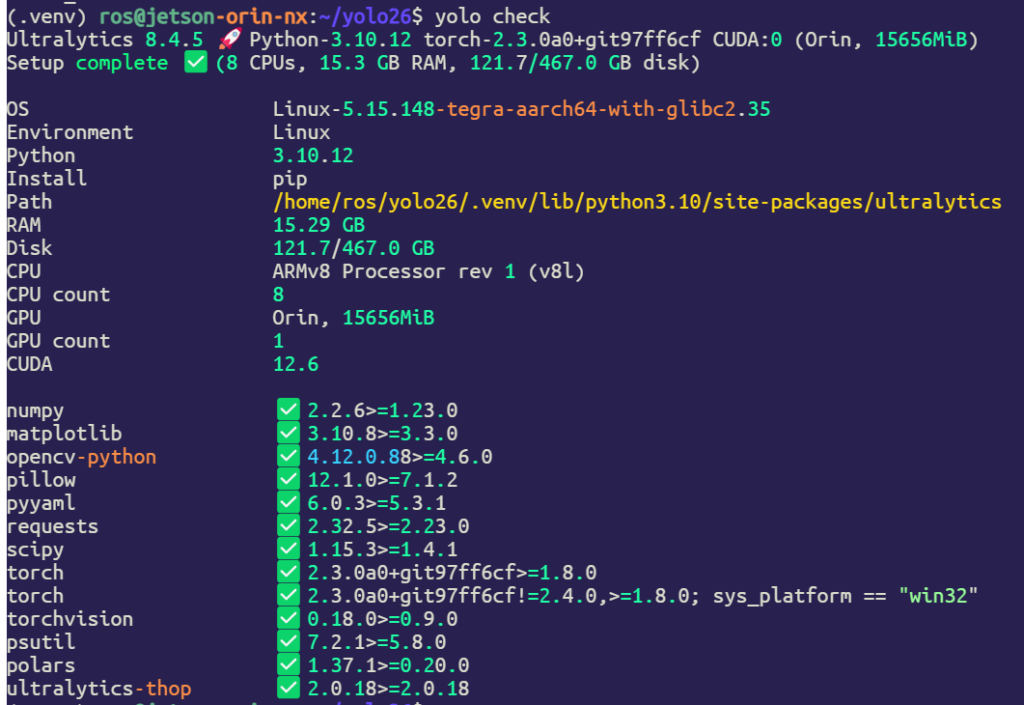

验证 YOLO

source .venv/bin/activate

yolo check

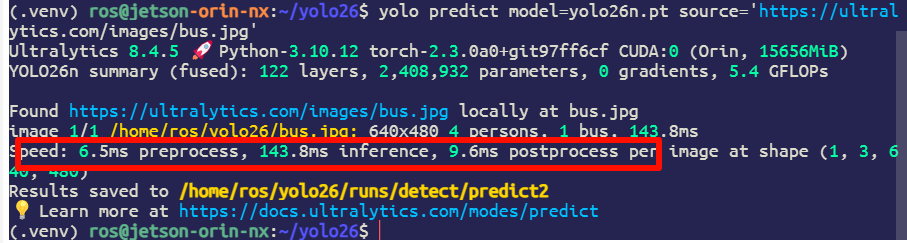

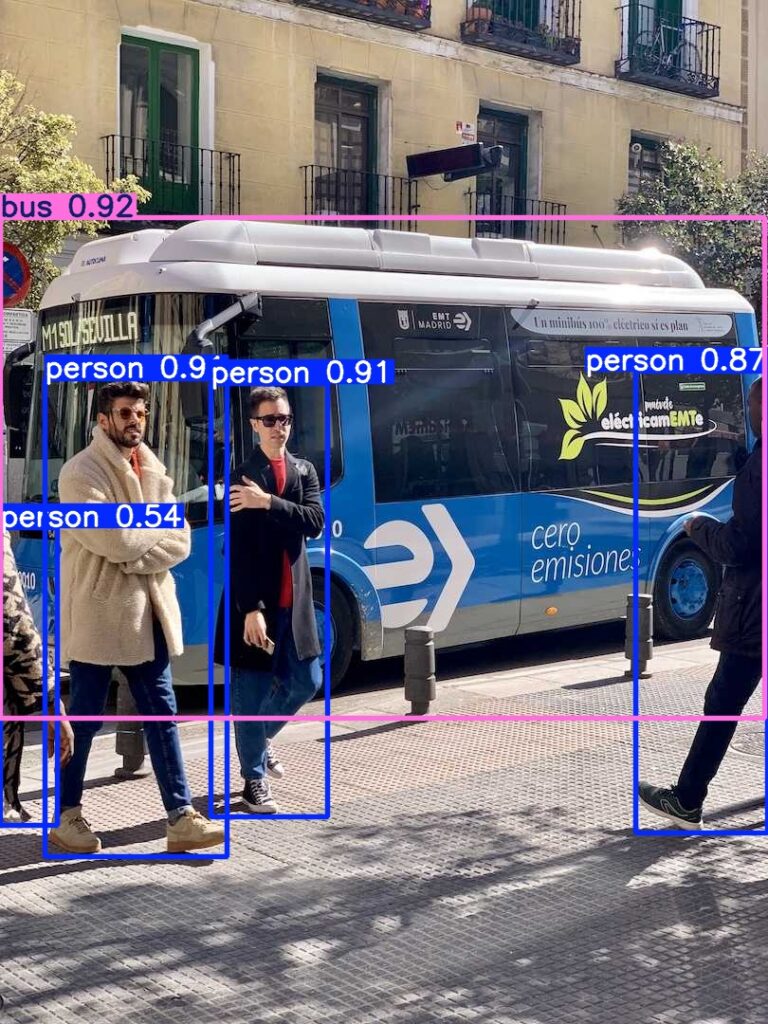

推理 YOLO26

# 在虚拟环境下运行

yolo predict model=yolo26n.pt source='https://ultralytics.com/images/bus.jpg'

竟然要 143.8ms ?别急,接下来我们将使用 TensorRT 量化加速模型

推理 YOLO26 TRT

首先需要安装 onnx

uv pip install onnx onnxslim

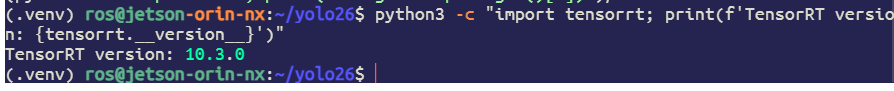

关于 TensorRT,可以通过软链接指向系统的 TRT 包命令如下(但需要虚拟环境与系统的 Python 版本统一,即3.10,不然会报错,自编译指南)

ln -sf /usr/lib/python3.10/dist-packages/tensorrt* $(python3 -c 'import site; print(site.getsitepackages()[0])')/

python3 -c "import tensorrt; print(f'TensorRT version: {tensorrt.__version__}')"

回显版本则说明链接成功

然后我们可以开始导出 TRT engine(会报错 onnxruntime-GPU 的问题,不用在意,如果硬要装也可以,自编译 Jetson Zoo预编译 煮包预编译,里面也有 TRT 的预编译包,安装就不用软链接了,不过并没有什么区别)

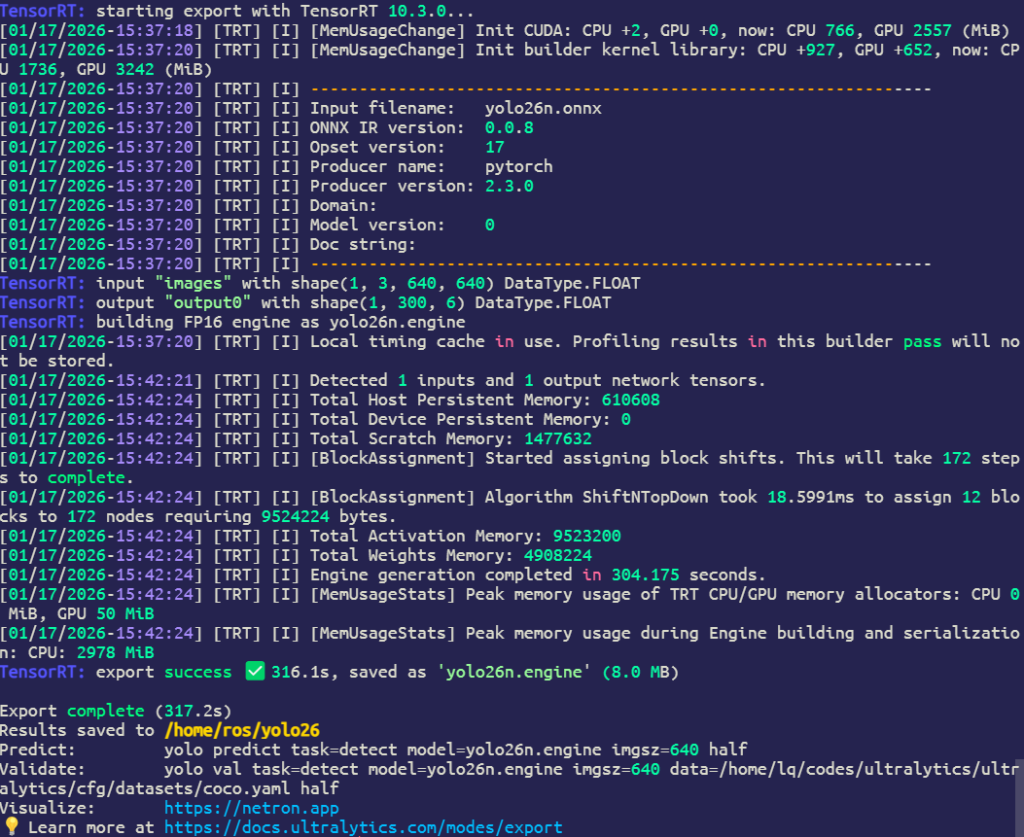

yolo export model=yolo26n.pt format=engine half=True device=0

导出成功后然后我们可以继续推理了

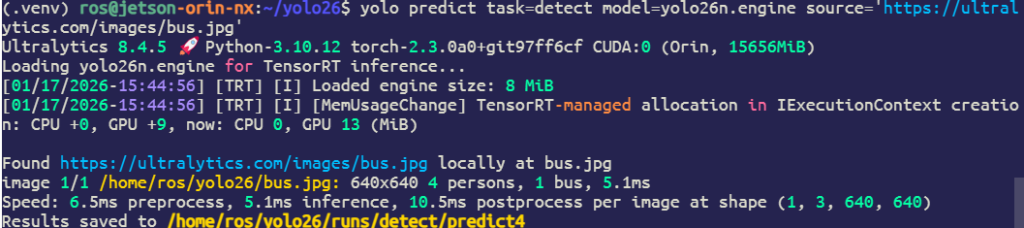

yolo predict task=detect model=yolo26n.engine source='https://ultralytics.com/images/bus.jpg'

可以看到 推理速度已经达到个位数了,实验非常成功 ✌️

Comments NOTHING